Abschlusstreffen von FrIDAH

FrIDAH-Projekt erfolgreich abgeschlossen: Sortier-Roboter in Aktion

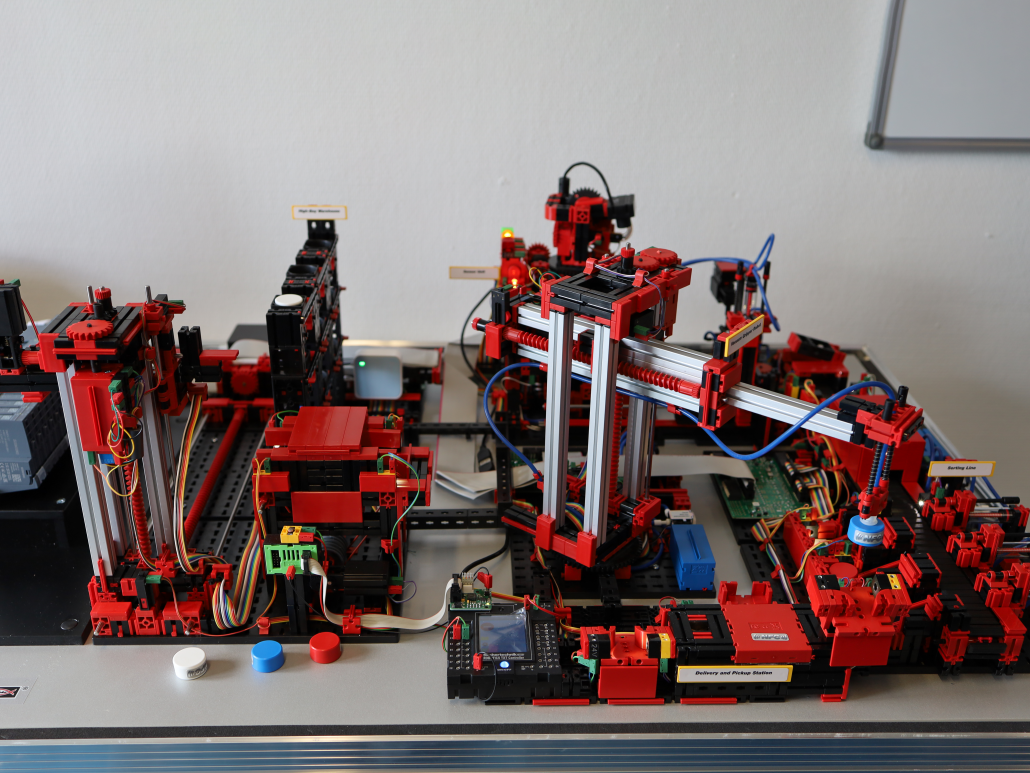

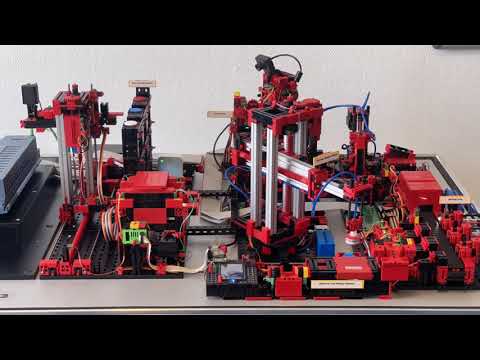

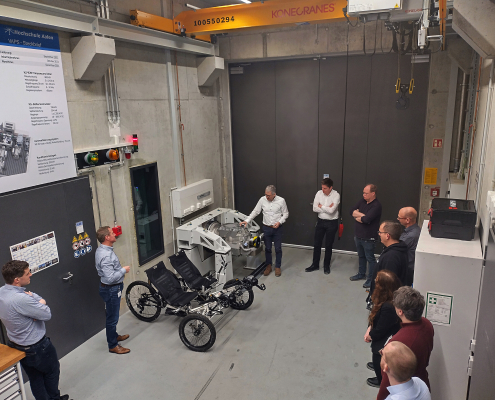

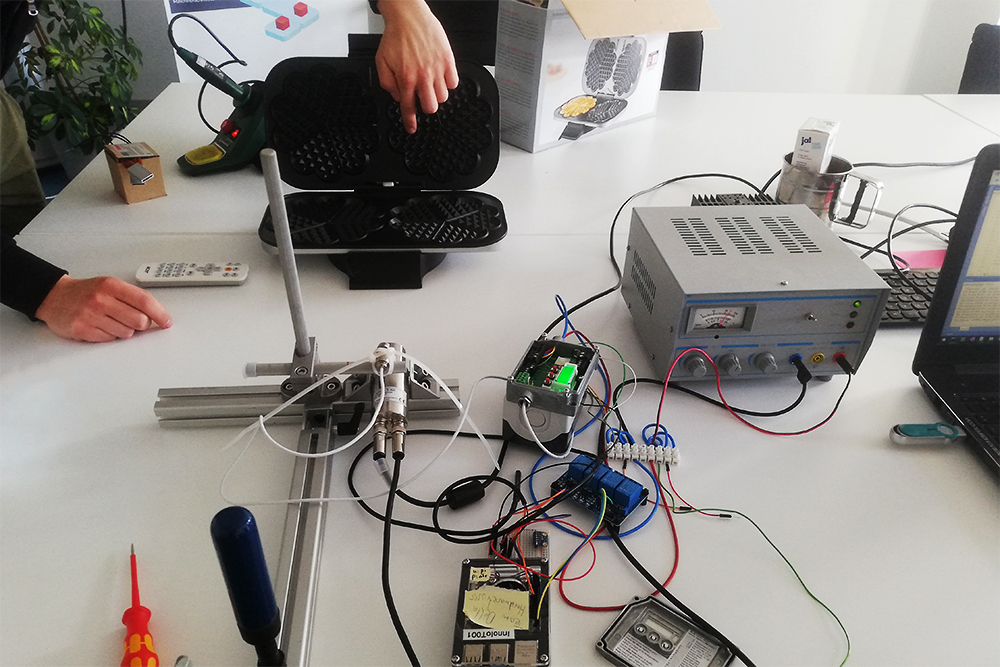

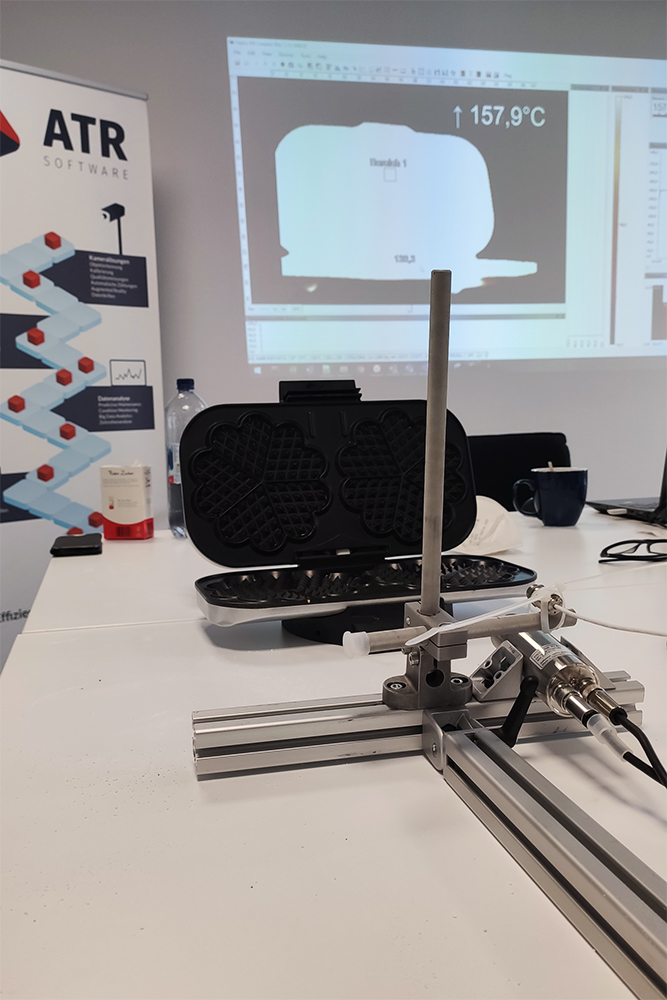

Nach drei Jahren Projektlaufzeit konnten wir das Projekt FrIDAH erfolgreich abschließen. Aufgrund dieses Anlasses fand am 20. Februar das Abschlusstreffen mit unseren Projektpartnern an der Technischen Hochschule Rosenheim statt. Bei diesem Treffen konnten wir die finale Version des Sortier-Roboters auf Herz und Nieren testen. Dieser Roboter funktioniert folgendermaßen:

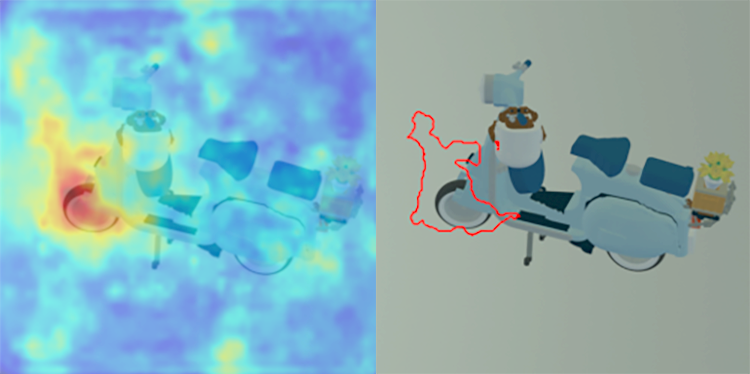

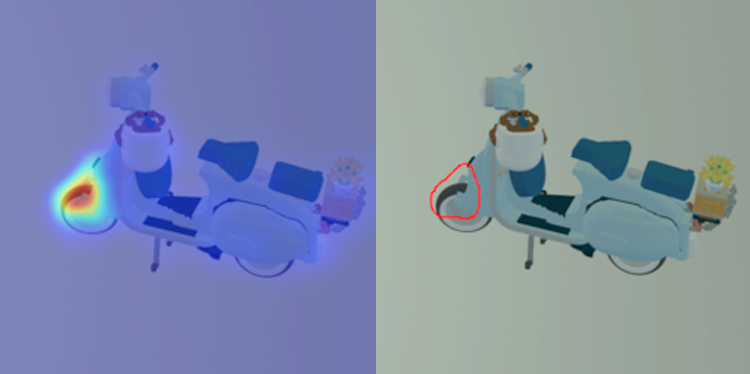

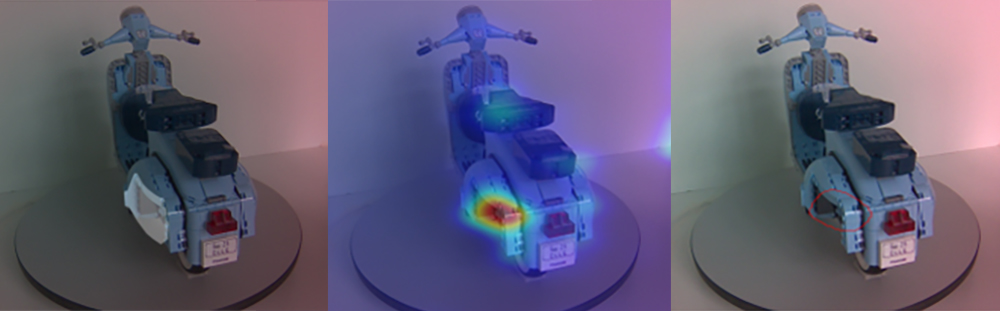

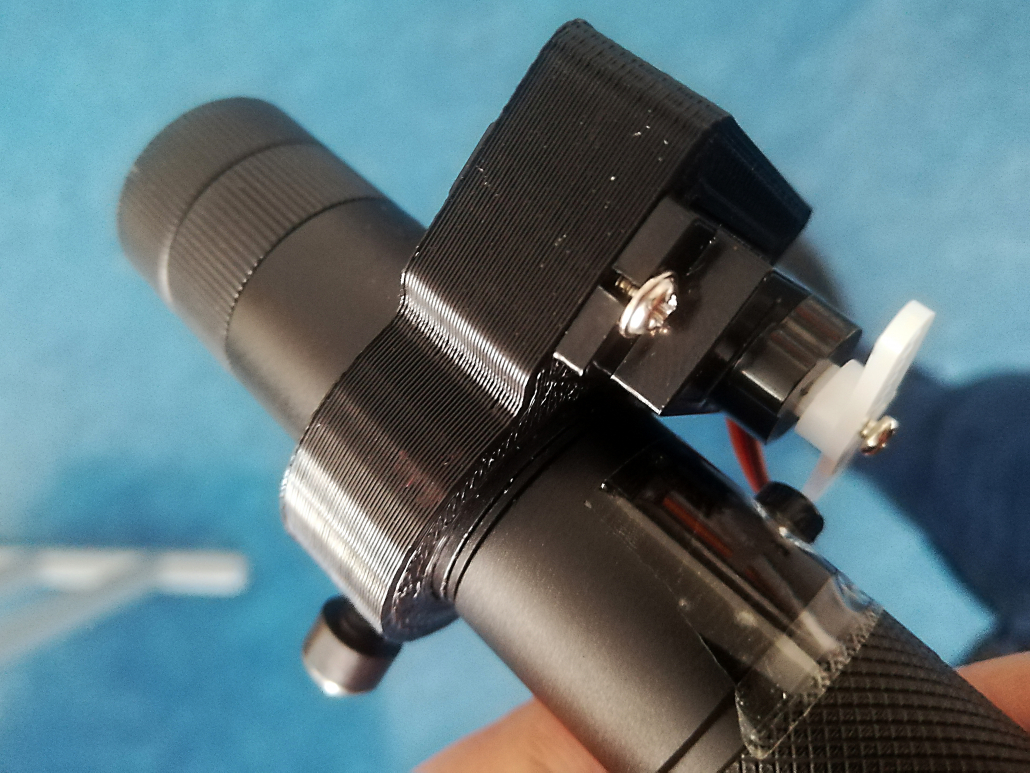

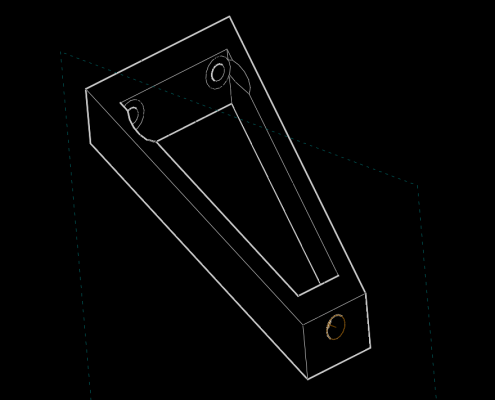

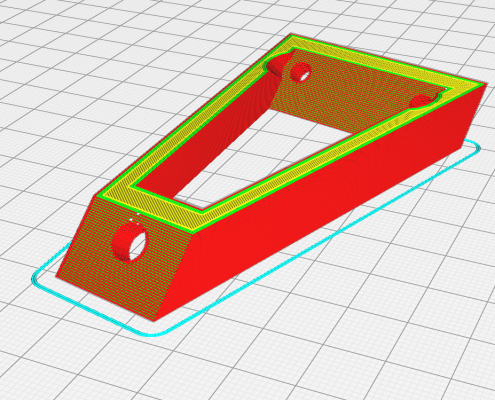

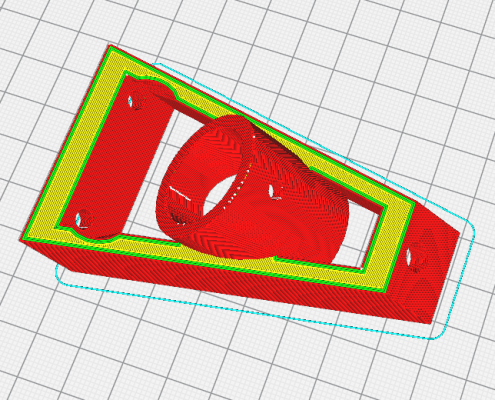

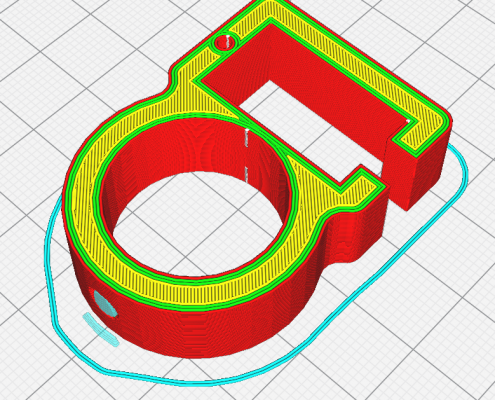

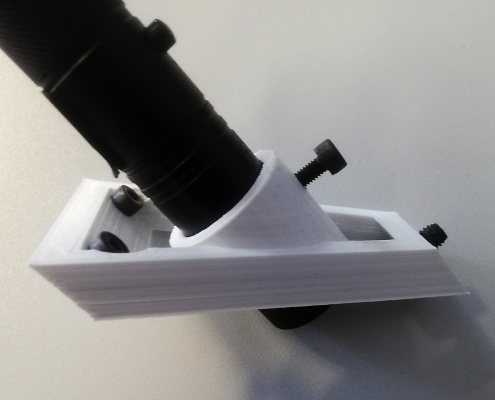

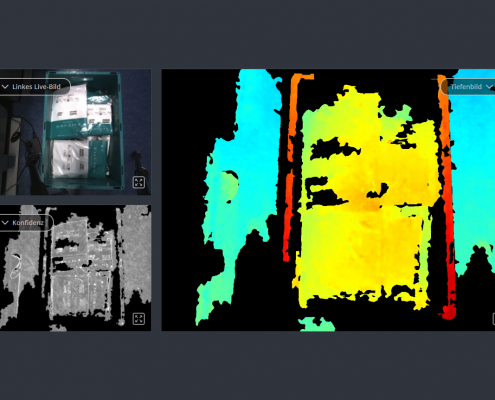

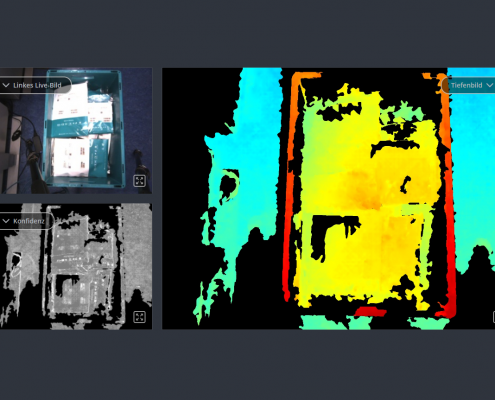

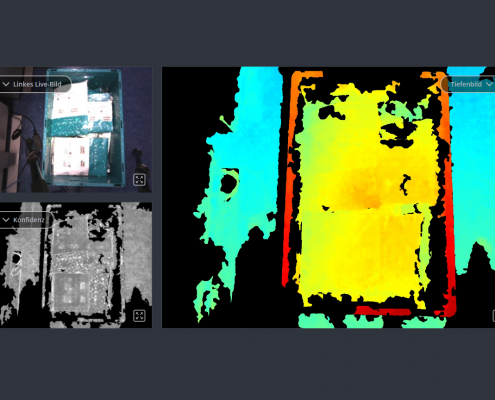

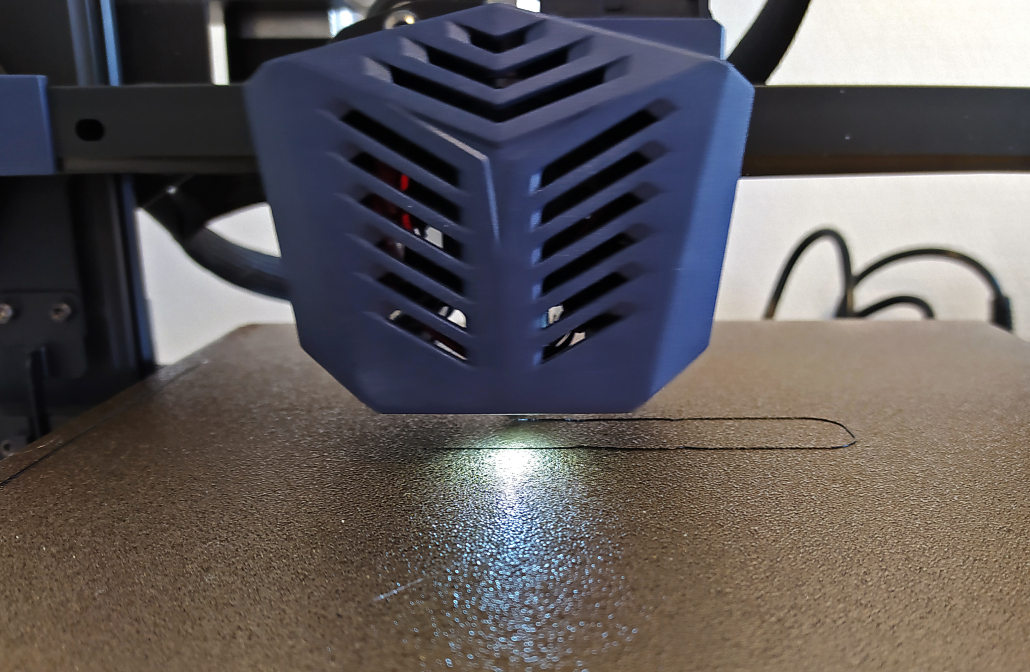

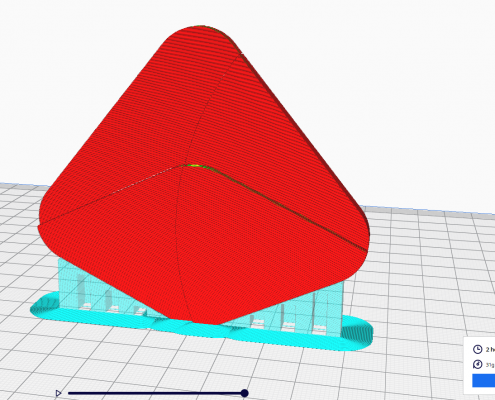

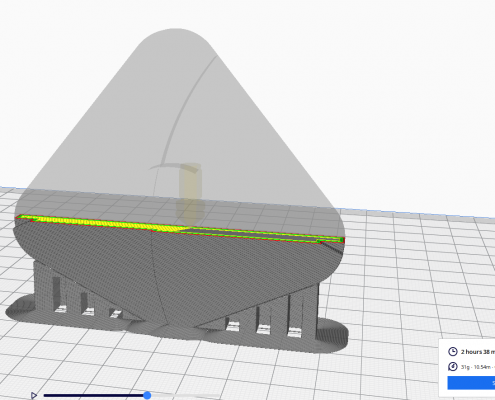

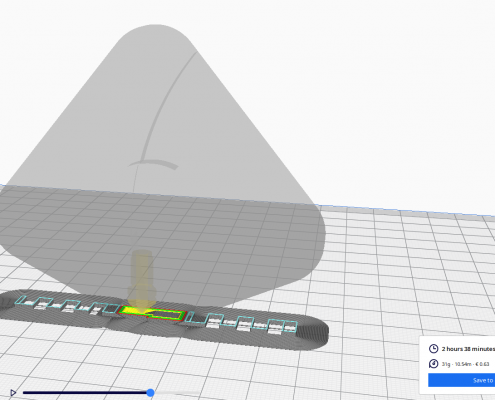

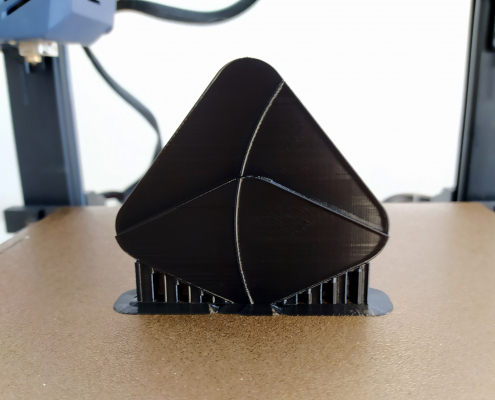

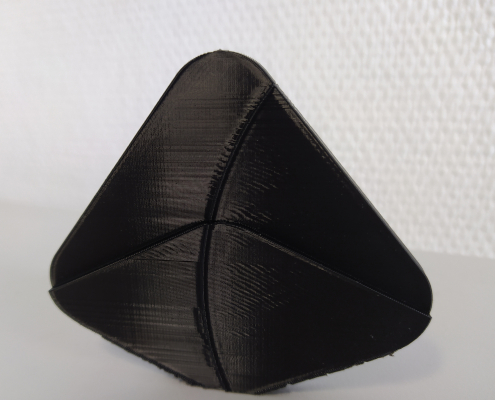

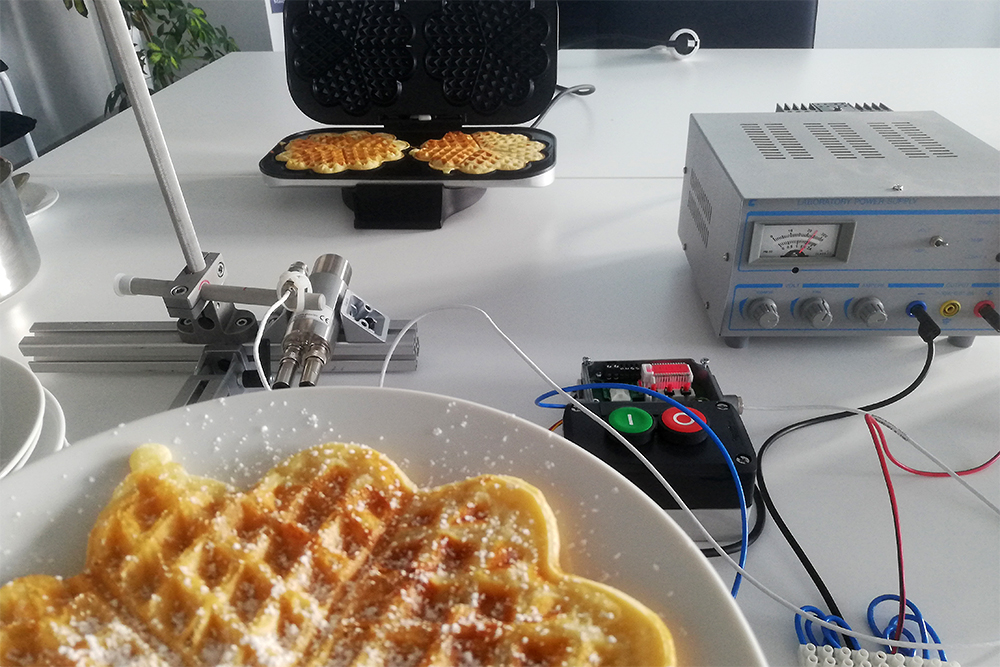

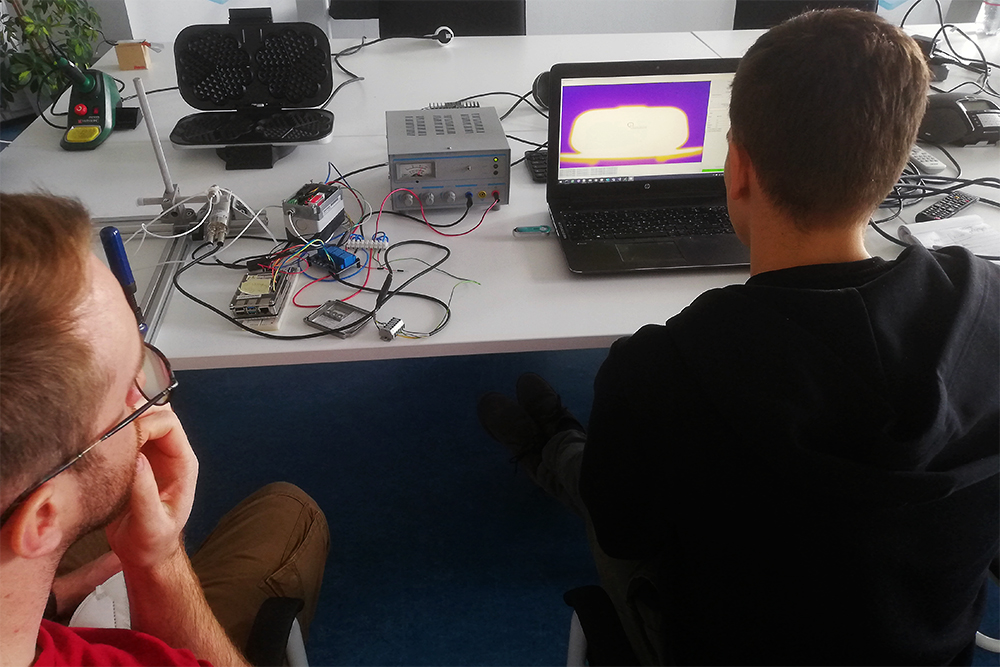

Der Roboter besitzt eine Kamera, die Objekte auf der weißen Fläche unter sich erkennen kann. Danach bewegt er sich zur erkannten Position, um das Objekt, in diesem Fall ein Holzstückchen aufzusammeln. Mithilfe eines Saugnapfs, der vorne am Roboterarm befestigt ist, wird das Holz angesaugt. Im nächsten Schritt wird es über die Kamera bewegt und wieder losgelassen. Die Kamera wird nun angesteuert und erstellt dann ein Fluoreszenzbild. Dieses Bild wird zur Kategorisierung der Holzgüte an unsere KI gesendet, die das Ergebnis, ob es sich um gutes oder schlechtes Holz handelt, an den Roboterarm zurückgibt. Dieser sammelt das Stück Holz wieder auf und ordnet es der passenden Box zu.

Das Video wird von YouTube eingebettet und erst beim Klick auf den Play-Button geladen. Es gelten die Datenschutzerklärungen von Google.

Wir freuen uns über eine gelungene Zusammenarbeit mit unseren Projektpartnern und über das tolle Ergebnis des FrIDAH-Projekts. Gemeinsam konnten wir eine innovative Technologie erarbeiten, die die Altholzsortierung zukünftig vereinfachen wird.

Hintergrund

Holz gilt als einer der wichtigsten nachwachsenden Rohstoffe weltweit und ist ein essenzieller Bestandteil des Wertstoffkreislaufs. Mithilfe von speziellen Recyclinganlagen kann das Holz in vier verschiedene Güteklassen eingeteilt werden. Danach wird entschieden, ob das Holz recycelt werden kann oder aufgrund seiner Beschaffenheit entsorgt werden muss. Die Sortierung erfolgt jedoch immer noch von Hand, wodurch Holz oftmals in eine geringwertigere Güte eingeteilt wird und somit entsorgt werden muss.

Um diese Problematik zu lösen, wurde das Forschungsprojekt „FrIDAH“ (Fluoreszenz-ID von Altholz) ins Leben gerufen. Ziel des Projekts ist die Automatisierung der Altholzsortierung mithilfe der Fluoreszenzlebensdauer und künstlicher Intelligenz. Wenn Sie mehr über das Projekt FrIDAH erfahren möchten, können Sie weitere Informationen auf der Webseite in unserem Forschungsbereich finden.

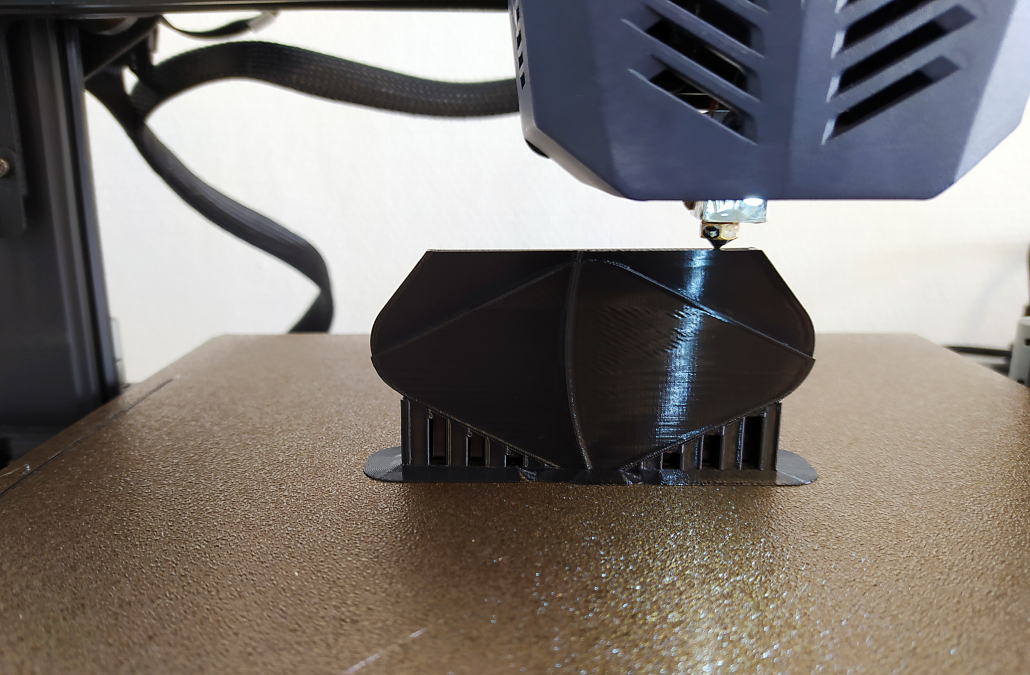

Wir von ATR Software unterstützen das Forschungsprojekt und unsere Projektpartner mithilfe unserer Expertise in den Feldern Software-Engineering, Data Science und Künstlicher Intelligenz. Das Endziel des Projekts ist der Bau eines Roboters, der mithilfe unserer KI das gute Holz vom Schlechten unterscheiden und somit die Altholzsortierung automatisieren kann.